Le fichier robots.txt est un outil essentiel pour améliorer votre SEO et faciliter l’exploration de votre site web par les moteurs de recherche tels que Google. Dans cet article, nous examinerons comment ce fichier fonctionne, pourquoi il est important pour votre référencement et comment vous pouvez l’utiliser pour optimiser l’indexation de vos contenus.

Qu’est-ce que le fichier robots.txt et pourquoi est-il important ?

Sommaire

Le fichier robots.txt est un simple fichier texte qui peut être trouvé à la racine du répertoire de votre site web. Il donne des instructions aux robots d’exploration des moteurs de recherche sur la manière dont ils doivent explorer et indexer les pages de votre site. Ces robots, également appelés « crawlers » ou « spiders », sont utilisés par les moteurs de recherche pour parcourir régulièrement le web, découvrir de nouveaux contenus et mettre à jour leurs résultats de recherche.

L’utilisation d’un fichier robots.txt bien conçu permet de :

- Contrôler l’accès aux parties spécifiques de votre site que vous ne souhaitez pas voir indexées

- Éviter le gaspillage de bande passante et de ressources serveur en empêchant les robots d’explorer des fichiers inutiles ou redondants

- Fournir des informations supplémentaires aux robots, telles que l’emplacement de votre sitemap XML

Il est crucial de comprendre que le fichier robots.txt n’est pas une méthode infaillible pour bloquer l’accès à vos contenus. Les robots d’exploration peuvent choisir de ne pas tenir compte des directives du fichier, et les utilisateurs malveillants peuvent toujours accéder aux fichiers interdits. Cependant, pour la plupart des moteurs de recherche réputés (comme Google), le respect des directives du fichier robots.txt est un élément clé de leur fonctionnement.

Comment créer et configurer votre fichier robots.txt

Pour créer un fichier robots.txt, vous pouvez simplement ouvrir un éditeur de texte tel que Notepad ou TextEdit, et enregistrer un nouveau fichier avec l’extension .txt. Vous devez ensuite ajouter les directives appropriées au fichier, en les séparant par des sauts de ligne. Voici quelques-unes des directives les plus couramment utilisées :

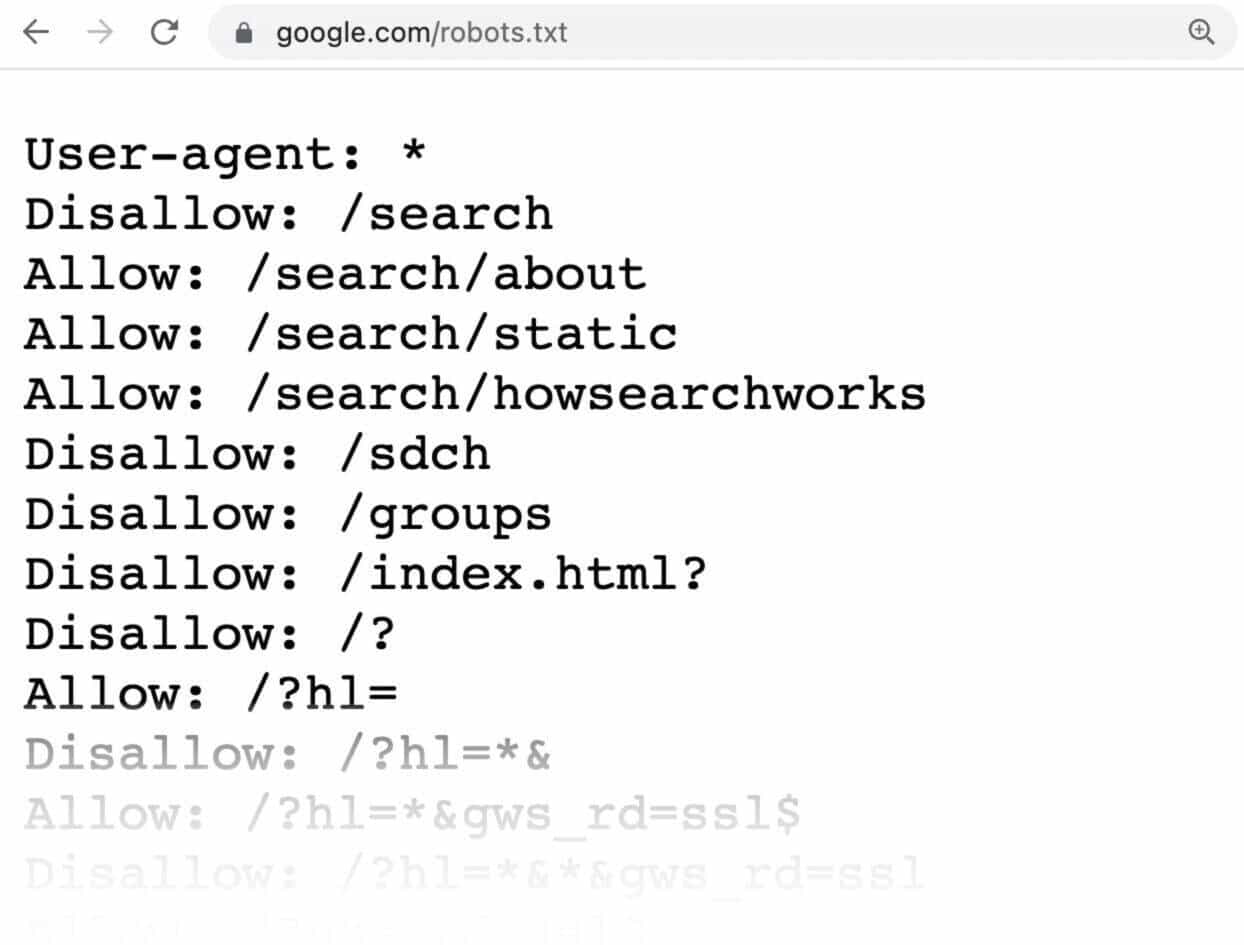

- User-agent : Cette directive précise le robot d’exploration auquel s’applique la règle. Par exemple, « User-agent : Googlebot » indiquerait que la règle s’applique uniquement au robot d’exploration de Google. Vous pouvez également utiliser un astérisque (*) pour cibler tous les robots, comme dans « User-agent : * ».

- Disallow : Cette directive indique au robot d’exploration quelles parties du site il ne doit pas explorer. Par exemple, « Disallow : /private/ » empêcherait les robots d’explorer le répertoire « private » de votre site. Pour bloquer l’accès à tout le site, utilisez « Disallow : / ».

- Allow : Cette directive est utilisée pour autoriser l’exploration de certaines parties d’un répertoire interdit. Par exemple, si vous avez bloqué l’accès à tout le répertoire « private » avec « Disallow : /private/ », mais que vous souhaitez autoriser l’exploration d’une seule page dans ce répertoire, vous pouvez utiliser « Allow : /private/public-page.html ».

- Sitemap : Cette directive indique l’emplacement de votre sitemap XML aux robots d’exploration. Par exemple, « Sitemap : https://www.example.com/sitemap.xml ».

Bonnes pratiques pour optimiser votre fichier robots.txt

Pour tirer le meilleur parti de votre fichier robots.txt et améliorer votre référencement, voici quelques bonnes pratiques à suivre :

- Utilisez des directives claires et précises : Assurez-vous que vos directives sont bien structurées et faciles à comprendre pour les robots d’exploration. Évitez d’utiliser des caractères spéciaux ou des espaces inutiles, et testez toujours votre fichier pour détecter les erreurs éventuelles.

- Bloquez uniquement les contenus sensibles ou redondants : Ne bloquez pas l’accès à toutes les pages de votre site, car cela pourrait nuire à votre indexation et à vos résultats de recherche. Concentrez-vous plutôt sur les contenus sensibles (comme les pages d’administration) ou redondants (tels que les fichiers PDF identiques au contenu HTML).

- Mettez régulièrement à jour votre fichier robots.txt : Comme pour tout autre aspect de votre référencement, il est important de maintenir votre fichier robots.txt à jour et de l’ajuster en fonction des évolutions de votre site et de vos besoins.

- Vérifiez régulièrement les erreurs d’exploration : Utilisez des outils tels que Google Search Console pour surveiller les erreurs d’exploration liées à votre fichier robots.txt et résolvez-les rapidement pour éviter un impact négatif sur votre indexation.

Exemple de fichier robots.txt bien optimisé

Voici un exemple de fichier robots.txt bien conçu pour un site web imaginé :

User-agent : *

Disallow : /private/

Allow : /private/public-page.html

Sitemap : https://www.example.com/sitemap.xml

Ce fichier interdirait aux robots d’explorer le répertoire « private », autoriserait l’accès à une seule page publique dans ce répertoire et fournirait l’emplacement du sitemap XML. Avec ces directives simples et claires, vous pouvez aider les moteurs de recherche à mieux explorer et indexer votre site, améliorant ainsi votre SEO et vos résultats de recherche.